- 週末原稿 2025/11/04

- 11/16(日)都市伝説解体センターオンリー情報まとめ 2025/10/23

概要

都市伝説解体センターオンリー 調査ファイルNo.00 SP2025に参加します!

日時:11/16(日)10:30~15:30

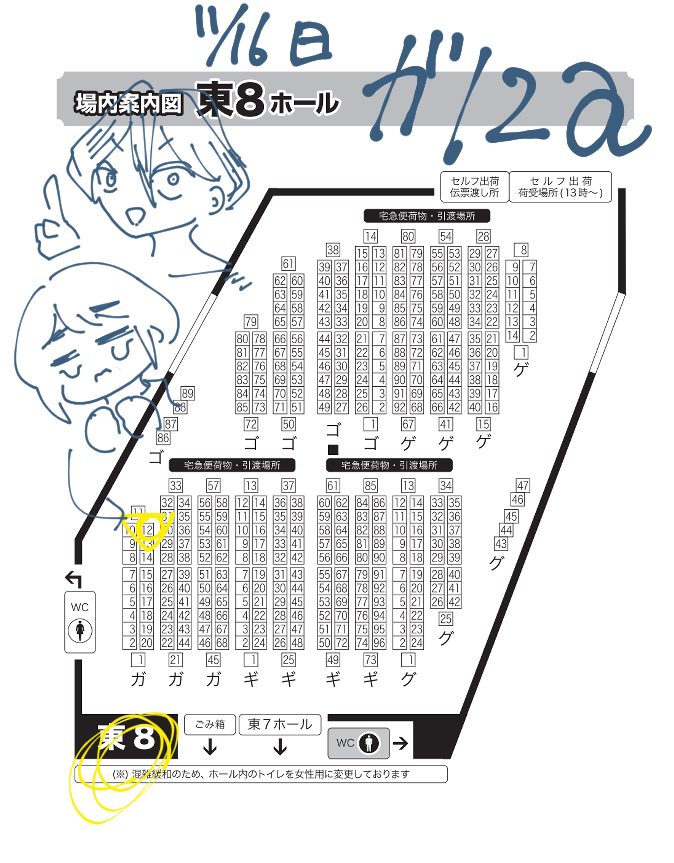

場所:東8ホール ガ12a Shorten

(赤ブーパンフレットより画像お借りしました)

リンク集

電子カタログNAVIO(プレミアム先行公開中/一般公開11/12)

Twitter情報集約ツリー

pixivサンプル頒布物

同人誌「都市伝説異解譚」

A5/42P/700円

原作軸シリアス漫画

ゲーム本編最終話の内容を含みます

オールキャラ(廻屋渉、福来あざみ、止木休美、富入順蔵、あの人、他)

サンプル

通販:BOOTHページ(余部が出た場合のみ)ミステリ小説推薦ペーパー(無配)

A5/8P(予定)/無配

都市伝説を解体したオタクにミステリを大推薦するペーパー。あと1P漫画。これが目的でスペース取ったので、全員に貰ってほしい!

本編ネタバレはありますが、紹介するミステリの致命的なネタバレはしないよう配慮したつもり。

サンプル:都市伝説を解体したオタクはこのミステリを読め!(虚構推理編)重ねて解体!アクリルキーホルダー

7cm×7cm/1000円

- 手+あざみセット

- 手+渉セット

7cm×7cm/各1000円

何の変哲もない(?)かわいいアクリルキーホルダー。ぴかぴか。手は裏面から印刷されているのできれいに重なるところがお気に入りです。

- 雀荘訪問記(Go20) 2025/10/13

先月なかったから珍しく2部両方いた。楽しかった~

- 2pが全部見えたにも関わらず1p切りリーチ→最終が135pの形は候補になる

- 3巡目 345679p23s667m西西+なんか。ドラも何もないけどもう平和の十分形だから9pがいらないと思ってしまった。でも8p引いたら一通を見るルートも残る。完全一向聴に取るなら残らないけど、巡目次第では打点を見る選択肢があるということ。この巡目に安全度のことは考えない。悪い癖と言われた。そ、そこまで損……!?確かにmaxを逃していても気がついてなさそう。面白い。オーラスとかやってそう

- 6巡目 34567p2223s667m西西。一番広いのは勿論3sだが、4s引きなら西西と行きたいから6mでどうだ。これはいい感じに選択できた!

- 自巡西が暗刻になって聴牌逃し。2sか西を切ってリーチ。西が1切れなのでカンできる2sを残してリーチ。2sカンして7001300を申告できた。嬉しい!

- 5巡目 11123457m456p224s。ドラなし聴牌。7m切って一向聴戻し。6m引いたら456がある(そうなんだ)

- 実践で始めて?8枚ウィング形を認識した。34456778sは25s69s47s待ち。両面嵌張がいるって本当だったんだ……

- 4s雀頭で356778の469s待ち

- 7s雀頭で344568の257s待ち

- あがらないとキツイ南場でライバルの上家からリーチ。4578m2278p5778s西。無理やり断ヤオで鳴いていこうかと思ったが余計急所を増やしているとのこと。ですよね……

- 113479北北西西中(ポン)白白白。ホンイツ。満貫が必要な場合はチャンタになるように4mを切る。おー。見逃しがち。確かにホンイツってチャンタと複合しやすいのか。

- 9巡目 45pr56899s5688m西西。0面子……。七対子というか流局時聴牌を目指す手。安全度は高いから西以外は鳴いてケイテンに向かって良し。

- 東場親 4巡目 7p2445689m46679s東。孤立ダブ東よりも9s切りでよい。6sは横に伸ばすイメージで9sはあまり使わないと思っていい。この形確かに嫌うことも多いんだけど、字牌よりは残しちゃってるかも

- ドラ8m 23445688m246677s。一番広いのは7sで、24sとは2枚差。24sは好形が残る可能性があるのとポン聴が取れる。24s切る場合は46677の形は4sあることで受けは広がらないことに注意。

- 打点の種は3色に求める手牌。11237s234m124689p。1sが雀頭候補になったことで234寄りになったがそれでも19pの比較はもう一度123に戻る可能性を残して9pが候補になる。そうやって決めるのか!

- 3巡目ドラ8p 12377m11345r5678p。1p2pは1切れ。聴牌外しは7mで十分。ドラ2なので一気通貫は見ない。

- ドラ4s 3r555456888p12s78m、こんなものは12s外しだ!ドラ4sだが親現を持って2sから外しでもいいくらい

- ドラ4s 最終的に12344s234568m45pになった手。ライバルからリーチ。8mぶった切りたかったけど14sを落として安全に回ることを優先する

- 麻雀プロのファンアートを描くコツ 2025/09/16

麻雀プロのファンアートを描くコツ

麻雀プロを応援し始めて早いもので5年が経った。生まれてこの方二次元のオタクとして生きてきたので、その延長でたまに麻雀プロの絵を描いている。三次元ファンアートひよっこの私だが、最近少しはコツも掴めてきたので、ファンアートを描くコツを伝授しよう!

情報を集める

- いろんな写真を見る

- いろんな情報を仕入れる

構図の段階から勝負は始まっている。神絵師でない我々としては、麻雀中の所作や普段の仕草でそのプロらしさを出せるなら是非とも採用したいところだ。だから会ったことがある麻雀プロは、直接見たポーズを描くわけでなくとも、なんとなく雰囲気を掴めて描きやすくなる。いい話。麻雀プロに会いに行こう。お金も落とせる。

全然関係ないが、大学生の頃、部誌にイリオモテヤマネコを描いたトラウマを思い出した。先輩に「耳の特徴をよく捉えてるね。腹の毛が足りないから剥製の写真を参考に描いたんでしょ」と言われたのだ。情報ソースは複数使おう。特徴を強調する

- ツリ目とタレ目

- 目と眉の距離

- おでこの広さ

- 耳の大きさ

- 唇の厚さ

- 頬の輪郭

- 顔の皺

この辺りの顔の特徴は重要だ。これは麻雀プロというか似顔絵を描くコツだが。

特に、複数人を同じ画面に描く時や、顔が似ている麻雀プロがいるときには外見の差異がどこにあるのか意識しよう。手癖でデフォルメしないように気をつける

三次元の人間を描いていると、二次元のキャラクターを描くときにいかに記号に頼っているかを思い知らされる。私も曲がりなりにも絵描きとして絵柄と呼ばれるものをもっているが、初描きの麻雀プロを描くときにはそのようなルールを全て一度無視するものとしている。手癖で描いてしまうと、上で書いたような特徴を捉えそこねてしまうからだ。特に耳や鼻は二次元のイラストでは差別化はしないことが多い。個人的には目も苦手だ。女性麻雀プロの瞳の表現を安易な美少女的デフォルメに頼ってしまうことが多いので、女性の麻雀プロは男性よりずっと描きにくい。

頑張って描いたファンアートなら喜んでもらえるというナイーヴな考え方は捨てろ。

さて。ここまで読んだ貴方は思ったかもしれない。「うっせーよ」「好きに描かせろ」「なんか失礼じゃない?」「それで麻雀プロに喜んでもらえるかどうかはわかんなくない?」

最後の質問から答えることにする。ファンアートを描いてもらえたら嬉しかろうというのは二次元オタクの感性だ。麻雀プロは二次元オタクじゃないから喜んでもらえるかどうかなんてわかるわけがない。例えるなら、雀荘のゲストに好物も調べず甘いものを差し入れるようなものだ。アレルギーがあったらどうするんだ。

上に述べたコツからわかるかもしれないが、私のファンアートを描く上でのこだわりは、その麻雀プロだと特定できる絵を描くことだ。けれどもそのために私が誇張して描いた特徴は、そのプロにとってはあまり好きではない身体の特徴かもしれない。

女性の麻雀プロは写真を撮られるアプリにも気を使うと聞く。だったら、似せて描くよりも可愛く描かれたほうが嬉しい麻雀プロだっているかもしれない。

容姿を似せて描くことは自己満足だし、その麻雀プロの容姿から離れて己の絵柄で可愛く描くことも自己満足だ。でもそんなことを言っていては何も描けない。私は勝手に実在する人物をモデルにして絵を描いて、それを公共の空間に貼り付ける人間だ。誰にも依頼されてない。私が描きたいと思ったから描いた。あくまで自分の表現だというスタンスを崩しちゃいけない。モデルに喜ばれることを第一義にはできない。だから「好きに描かせろ」というコメントにはこう応じるしかない。「好きに描いてください」。

それが応援につながるかどうかは、受け手、つまりモデルとモデルのファン達に委ねられていて、作者がそれを決めることはできない。精々できるのは、名誉毀損になるような失礼な表現がないよう気を配ることくらいだ。それでも頑張って描くしかない

それでも頑張って描いたファンアートにしか価値はない。

なぜなら間接的に、共通認識の末に、その頑張りがファンアートを応援の手段として成立させているからだ。つまり、絵を描くのは大変で、その大変なことをしてくれるほど、この人は私を応援してくれるファンなのだと伝わるからこそ、喜んでもらえるからだ。

二次元オタクがどうしてファンアートを善なる応援だと信じられるのか。それはオタクが努力の末に描かれた二次元アート作品で育ったからだ。だからこそ、その頑張りを評価してくれるかどうかはその麻雀プロの価値観次第だ。絵を描くことを趣味としている麻雀プロはその苦労をわかってくれるかもしれない。オタク文化に接している麻雀プロは私達と同じ目線で喜んでくれるかもしれない。でも多くの麻雀プロは二次元オタクとは全く異なる文化圏で育っている。それは頭に入れて、勘違いしないようにしなくては駄目だ。

ここに至って、最早絵の技術力は重要ではない。小学生が描いたファンアートを、下手だからといって喜ばない麻雀プロがいるだろうか。

さらには、これはイラストレーションではなくても成立する話だ。例えば、麻雀プロの写真を収集し、並べて装飾するコラージュ的作品も嬉しいと思うプロがいるだろう。

加えて現在の状況では、画像生成AIが作る画像はファンアートとして受け入れられない可能性がある。なぜなら、済まない。頑張っていないからだ。ヌクモリティがないからだ。プロンプトは工夫したのか? どれくらいその絵のこと考えたんだ? それが鑑賞者にも伝わる絵になっているのか?麻雀プロのファンアートを描くコツは、プロに喜んでもらいたいだなんて思わないことだ。

そして、そのプロのことを考えて、心を込めて描くことだ。 - Protected: 解体アクリルキーホルダー 2025/09/04

- 雀荘訪問記(Go19) 2025/08/17

- 1235p24s455r56788m:今マンズは5m8mが雀頭候補。だが8m1切れで5mはあと1枚しかない。8m切って45678mの形に固定すると5pくっつきで24sを払える

- 全体的に両面だからって待ちを安易に決めない。カウントする。降りてるときも安易に合わせない。確かにこれは中級者のよくない癖ってかんじがする。私も形式聴牌率が低いのはここが影響してそう

- 中中白南46s1146m235r5p。中はポンするなら良形ターツは足りている。打点アップのために役牌の白南を残すのはどうか。

- 一方でドラ3mなので46mターツは残す。残している限りはドラ引きの抽選が受けられる

- 34s1167m235r5p東(ポン)中中中:全員の無スジ1mを落として安全牌を抱える構え

- 46s34r567p2344m北北(ツモ)1m:北を切ろうと思ったけどここで1m切りでどうか?つまり平和の効率を落として断ヤオに向かう。北暗刻にも備えたい。

- 1356m34588p4468s:供託2。ドラ7sだけチー。他は鳴きたくない。

- 13356m344588p456s:供託2。8p2切れ。打1mで断ヤオを見ていく

- 麻雀をチーム戦にするもの 2025/08/10

麻雀をチーム戦にするのは誰か

「いま、最高の個人競技が、最高の団体競技になる」

言わずと知れた、MリーグのHPのトップに掲げられるキャッチコピーである。しかし、実際のところ一半荘の間にチームで行う作業は何もなく、競技自体は個人戦だ。昨年行われたRAGE麻雀 feat. M. LEAGUEではアドバイス制度や代走が導入されたが、今後も麻雀が真の意味でチーム戦になることはないだろう。

それでもMリーグがチーム戦足りうるのは何故か。試合後に議論する姿。チームメンバーのSNSでのやり取り。ABEMAの特番で明かされるエピソード。それらは全て試合の外の姿だが、その情報があるからこそ、Mリーガーはチームのために必死でトップを取ろうとしているように見えるのだ。設立1年目のアースジェッツ、3年目のBEAST X、7年目のサクラナイツを見てほしい。アースジェッツは団体混合のチームだから、まだ「チームとして」アースジェッツを応援しているファンはほとんどいないだろう。BEAST Xのように、これからコンテンツの発信を繰り返していくことで、チームのファンが増えていくのだろう。そしてサクラナイツのファンは二度のチームメンバーの入れ替わりを通して、個人を応援することとチームを応援することのギャップに向き合っている。Mリーグがチーム戦だという共同幻想は、運営する側が演出し、観客が受け取ることで保たれている。

Mリーグをモデルとして、様々な麻雀のチーム戦が行われている。しかし、雀士を集めてポイントを共有させればチーム戦になるというものではない。そこには演出が必要なのだ。チームは一日にして成らず:世界麻雀

先日第4回となる大会が行われた「世界麻雀」だが、今大会からはチーム戦が導入された。しかし、個人的な感想としては世界麻雀はチーム戦に見えなかった。どのチームを応援すればいいのかわからなかったのだ。一般に国際大会は自分が帰属する国を応援するものだろうが、日本のチームは45チームの中に8チームもあった。何をもって応援するチームを決めればよかったのだろう。多くの日本の麻雀ファンは、一番好きなプロがいるチームを本命と定めて応援したのではないだろうか。それは個人戦と何が違うのだろう。

また、チームが急造すぎたのも熱が入らなかった原因だ。チーム発表から大会当日までは1ヶ月しかなく、チームとして応援する材料を見つけられなかった。しかし、それでもプロ雀士の側は努力をした方だと思う。多くのチームが決起集会と称して顔合わせを行い、それをSNSに投稿していたのだ。大会に勝つことを考えた時、そんなことをする必要は全くなかったにも関わらず。

真に世界麻雀をチーム戦として成立させたかったならば、一国1チームに絞った、国別対抗戦をやるべきだったと思う。その予選や、チーム決定後の交流の演出を通して、「日本代表チーム」を盛り上げていくべきではなかったか。チーム分けの工夫:魂天リーグ

魂天リーグは麻雀ウォッチによって主催されているチーム戦だ。現在第2期が行われている魂天リーグだが、運営サイドがチーム分けを工夫してきたように見える。

例えば、渡辺プロ・西乃プロ・牧野プロからなるチームベガは「配信者チーム」と紹介されるし、木原プロ・梅村プロが所属するチームリゲルにおいては、しばしば二人の師弟関係が言及される。所属団体を意識してチーム編成が行われた第一回から、運営が工夫をしてきたことは明らかである。

ただ、残念なのは、そのように共通点の多い魂天リーグのチーム内でも、リーグ戦当日以外のチーム配信は現状行われていないことだ。唯一の例外は、神域リーグにも登場したVTuber達によるチーム、チームポラリスである。チーム作りのプロ達:神域リーグ

Mリーグにインスパイアされた麻雀チーム戦の中でも、神域リーグの成功は桁外れと言えるだろう。しかし、神域リーグは著名配信者達のリーグだったから成功した訳では決してない。著名な配信者達はチームをチームとして見せる術を心得ている、演出家であり演者だったから、神域リーグは成功を収めたのだ。

ドラフト後、即座に顔合わせ配信を行う。タグを作り、チームとファンの間に一体感を作る。このようなシステムは真の意味でのチームバトルを行うeスポーツの習慣を持ち込んだものだろう。しかし、本来の団体競技が行っている工夫を麻雀で行わず、どうして個人競技がチーム戦となりうるだろうか。

また、チームを作る制約の中にもチームらしさを生み出す工夫があった。初年度のみだったが、神域リーグには麻雀の実力に従ったランクが存在した。雀聖3からがAランク、雀傑3からがBランク、といった具合で、各ランクは一人ずつしかチームに所属できない。チーム間の実力の平等性を担保するためのシステムだったが、これは結果的にチーム内の師弟関係や、チーム間でのライバル関係を生み出すシステムとなった。

そのように本番の外の練習配信や交流会できた、配信者同士の「関係性」がチームを形作る。チームができるから、本番の応援配信が盛り上がるのだ。チームへの帰属意識:WROTL・海桜戦・新春まーすた麻雀チームバトル

ここまでは主に見て楽しむチーム戦について論じたが、私達が参加できるチーム戦も存在する。近年だと、龍龍が主催するネット麻雀のチーム戦「WROTL」が大規模だろう。これは主に龍龍ユーザーが参加して楽しむことを目的としたチーム戦だが、日吉プロ・滝沢プロ・本田プロ・日野プロが所属するチーム「1859」や、藤川プロ・早川プロ・西乃プロ・茨城プロが所属するチーム「イケメンアベンジャーズ」は、チームメンバーをゲストとしたリアル麻雀のイベントを行い、応援できるチーム戦としてもWROTLを盛り上げていたことは特筆に値する。

WROTLのように、麻雀のチーム戦といえば友人同士がチームを組むイメージの方が主流だろうが、実際には見知らぬ人同士がチームを組める麻雀チーム戦も存在する。サクラナイツとU-NEXT Piratesが2行うオンライン麻雀大会「海桜戦」はその一つだ。あらかじめ所属したいチームに申し込み、所属するチームとは無関係に卓組みが行われ、それぞれのチーム上位100人分の成績が計上されるシステムになっている。こうすることで、チーム間の人数の不平等性を緩和できるのだ。

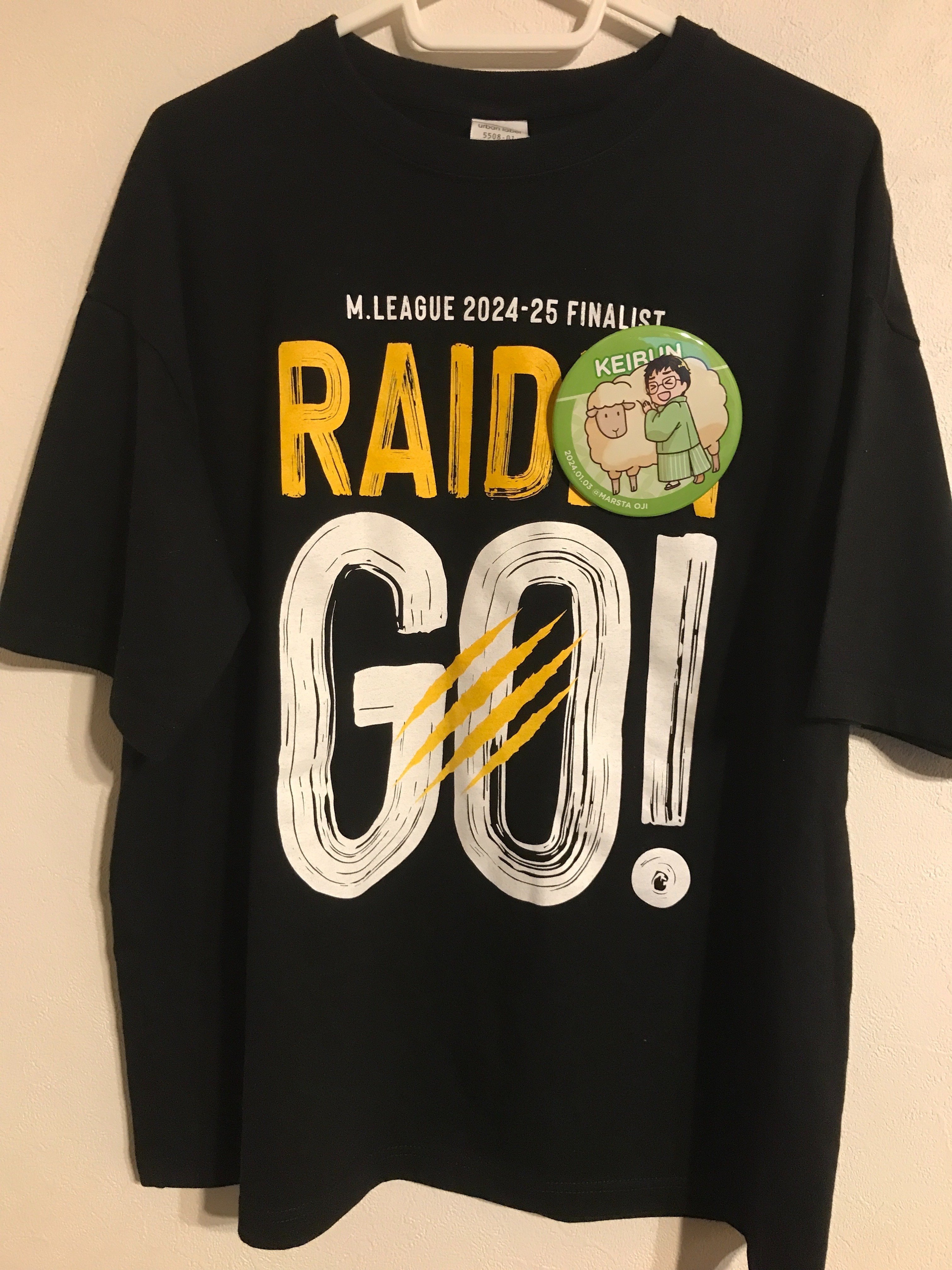

ただ、唯一不満があるのは、同卓相手がどちらのチーム陣営なのかわからないという点だ。つまりこの大会において、ファンはチームに帰属意識を持っているが、ファン同士は同じチームに帰属しているという連帯感を持てないのだ。大会用に雀魂の1日限定の称号を作って、それぞれのチーム所属者に専用の称号をつけてもらう、といったシステムを導入するのはどうだろうか。一方で、リアル麻雀の大会「新春まーすた麻雀チームバトル」は参加者がどのチームに属しているかをわかりやすく示している。ノベルティとして大きな缶バッチがついてくるのだ。

昨年の缶バッチ。羊が描かれているのは、新井啓文プロが未年生まれであることから 実は、このチームバトルは海桜戦とは違って、全半荘でチーム同士が対戦するように卓組みがされているので、参加者が条件戦を望まない限り、対戦相手のチームを認識できるようにする意味はない。しかし、多くの参加者が缶バッチを付けることで、チームメンバー同士の会話が生まれるのだ。麻雀イベントでの参加者同士の会話は卓内で行われるのが主なところを、チームメンバーを認識できることによって、もう一軸、会話の機会が生まれる工夫になっている。

#新春麻雀チームバトル – Search / X See posts about #新春麻雀チームバトル on X. See what people are saying twitter.com

参加者の多くがバッチをつけて記念撮影したり、バッチにサインを貰ったりしている様子から、このノベルティの効力が伝わるのではないだろうか。

まとめ

麻雀は本質的には個人の競技だ。それを私達がチーム戦だと感じられるのは、運営とチームに所属する雀士達がチーム戦らしさを演出するからだ。その演出がない麻雀はチーム戦ではない。ただのポイントを引き継ぐ個人戦にである。

- 会いたいな会えるといいな麻雀プロ 2025/08/08

同卓したプロを太字、見たことあるプロを下線にしていく

【連盟】

黒沢さん、瀬戸熊さん、ともくん、うしさん、魚谷さん、勝又さん、日吉さん、仲田さん、吉田さん、沢崎さん、はらまいさん、猿川さん、内川さん、ふるぽこさん、さくらさん、襟川さん、石田さん、りんかりんさん、川上レイさん、山田浩之さん、あいだてさん、早川健太さん【最高位戦】

近藤さん、けーぶんさん、醍醐さん、河野さん、あさぴん、ばっしー、ずんたん、丸山さん、優さん、瑞原さん、日向さん、茅森さん、そのけん、渡辺さん、土田さん、浅井裕介さん、小宮さん、独歩さん、品川さん、牧野さん、竹内さん、浅見さん、安達さん、ZEROさん、鈴木そーいちろーさん、しんごちゃん、平賀さん、ずむさん、後藤悠さん、後藤哲冶さん、成田さん、黒河さん、新榮さん、佐伯さん、はるぼーさん、かじりささん、坂本さん、小山さん、徳岡さん、設楽さん、小川さん、一馬さん、湖虎さん、大畠さん、来輝さん、林さん、坂井ザワさん【協会】

木原さん、須田さん、金さん、堀さん、渋川さん、いばらぎさん、綱川さん、佐月さん、豊後さん、松嶋さん、浅井堂岐さん、平良さん、うるりさん、杉村えみさん、明科さん、黄河さん、飯田さん、水口さん、下石さん【ミュー】

こばごう、忍田さん、下出さん、藤川さん、むくさん、うめぴこさん【RMU】

空川さん、一さん、渡辺卓也さん、がせさん、あかねさん、おがこうさん【他】

こばみささん、片山先生、おじさんさん同卓達成率:49/90

物理麻雀が打てるようになったらな

点数計算ができるようになったらな

会いたいな会えるといいな麻雀プロ - 雀荘訪問記(Go18) 2025/07/21

書くの2回サボっちゃった……。

- 聴牌でカンチャン選択。4枚vs3枚 リーチ者現物は1枚見えをひっくり返す

- 1366p2245s12368m。結構愚形リーのみになりそう。6p切ってほぐすとか……

- 113p112s245677m中中中。1pドラ。3p切って雀頭固定するのはどうか

- 5巡目。3478m12367s23889p。9p切って全ての両面を受け入れる。これ勘違いしてたかも……

- 112r5688m468p35r5s發。ドラ發。何か役が欲しくて112m落としたけどドラ切りが一手。

- 234s34p24677m南南南。ドラ4m。トップ目南2局。8800点差。ここで2000点差上がることも大事。テンパったらダマ聴でよい。点数状況のため。

- トップ目のオーラス。競りの2着目は親で、子に満貫までなら放銃できる点数状況。

自分の手は55r588m23467s南南、とか。表ドラもやや見えている。

『科学する麻雀 』によれば子が約6,000点、親が約8,400点程度。一発だけ避けてあとは67もチーしていいし、放銃してもいい感じで攻めていい。 - 終盤でも親で両面テンパったらリーチだ!!!

- 123r5p568m234599s。ツモ2s。ツモ切って赤5pか4連形にくっつけて外したいと思ったが、よく見たら1s3枚切れ3s1切れ6s2切れ。ということは3sを引いても嬉しくない。よく場を見れば即リーチ判断だ。

- 5r5s2223677m66p東西西。ドラ4m。とりあえず東切りと思ったけど木原さんは大きく対子手を見て3m切りらしい。ドラ引いたら七対子にすればいいと。確かに実際ドラ引いてもどうせ頭には使えないから難しい。

- 2367s568p136888m北。北ドラ。何も考えず8pを切ってしまったが、678を見よう。

- 都市伝説を解体したオタクはこのミステリを読め!(虚構推理編) 2025/07/09

都市伝説解体センターが流行ってから「都市伝説解体センターが好きな人はこのゲームもやって!」と言ったツイートが流れてきますけれども(私は「パラノマサイト」をオススメしたいです:おい!ミステリオタクのパラノマサイト感想聞いてくれやありがとう)、当方活字を愛するオタクなので強く言わせていただきたいです。

ミステリ小説を読め!!!

実際、ゲームやミステリに不慣れでも都市伝説解体センターが好きになった人って、テキストの味やミステリの構造が刺さったと思うんです。じゃあミステリ小説読みましょ。名作はいくらでもありますよ。そういう訳で、都市伝説解体センターが好きな人にオススメのミステリを紹介します。虚構推理

城平京 著(2011年)

あらすじ

主人公の岩永琴子は幼い頃に妖怪たちに連れ去られ、片目と片足を取り上げられて妖怪たちの知恵の神として祀り上げられることになりました。それ以来、琴子は妖怪たちの困りごとを解決しながら暮らしています。聡明でお嬢様で少し世間離れしている琴子も人の子。中学生の頃、病院で出会った桜川九郎に一目惚れしてしまいます。九郎は人魚と件(くだん)の肉を喰らった、不老不死とちょっとの未来改変能力をもつ普通の高校生です。九郎にはお付き合いをする女性がいましたが、琴子が大学生に上がる頃、ちょっとした事件で別れることになりました。それを知るや否や琴子はアプローチを決行。半ば無理矢理お付き合いを始めます。

そんな二人が妖怪たちの依頼で駆り出された先では、顔の潰れたアイドルの亡霊が現れて、夜な夜な鉄骨を振り回すとの噂。その噂は「鋼人七瀬まとめサイト」を通してネット上で拡散されていき、次第に都市伝説めいていきます。それに従って暴力性も増していく亡霊アイドル。琴子はそれを、現代人の妄想と願望が作り上げた「想像力の怪物」と呼びます。そしてついに出てしまった被害者は、九郎の元カノの関係者でした。果たして琴子と九郎は亡霊を退治できるのか……。というのが、虚構推理シリーズ第1巻「虚構推理」のお話です(もともとは「虚構推理 鋼人七瀬」というタイトルだったのが、講談社タイガに移ったときに改題されました)。都市伝説解体センターファンにココがオススメ!

都市伝説が活躍する多重解決ミステリ!

都市伝説解体センターが影響を受けたミステリとして、ファミ通のインタビューでは、京極夏彦の百鬼夜行シリーズが挙げられています。百鬼夜行シリーズはまるで妖怪が起こしたような事件を解決していくミステリですが、この妖怪を都市伝説に置き換えたものが都市伝説解体センターの構図だと語られています。虚構推理にも妖怪がたくさん登場しますが、1巻の鋼人七瀬編は明らかに妖怪ミステリでなく都市伝説ミステリです。その理由は、現代を生きる人の噂が謎を形作るからです。あなたも経験ありませんか? ツイッターで流れてきたそれっぽいツイート。最初は信じてしまったけど、フェイクニュースだった。いやいや、実はそれ実験でした、って。それ、多重解決です。

多重解決というのは、ミステリの解決パートの技工の一つで、要するに解決パートがいっぱいあるということです(「丸太町ルヴォワール」、最愛の作品なんで読んでください)。匿名の噂に隠れた都市伝説の真実は移ろいやすいもの。その移ろいやすさが虚構推理では多重解決という形で表現されています。どうして多重解決することが鋼人七瀬を倒すことにつながるのか? それは是非本編を読んでください。掛け合いがキュート!

私の都市伝説解体センタープレイ1周目の記憶ですけれど、ミステリオタクの悪い手癖でつい正解の選択肢を選んでしまって、結構あっさり終わらせてしまったんですよ。2週目で阿呆のあざみにセンター長が向ける視線が優しすぎて頭抱えたワケなんですが、都市伝説解体センターのユーモアあるテクストに気が付かず終わってしまうところだったなんて危ないところでした。

虚構推理も独特のユーモアを持つ作品です。岩永琴子、自信家で教養があってユーモラスだが下ネタが好きで少し変な女の子でして……。一挙一動一発言が可愛い。琴子をすげなく扱う九郎とのやり取りを楽しんでください。九郎の元カノに歯をむき出しで威嚇する琴子が可愛いのなんのって。シリーズ物&メディアミックス!

鋼人七瀬編だけでも十分楽しめますが、続きが欲しくなれば「虚構推理」に改題された講談社タイガからシリーズ化されています。さらにコミカライズとアニメ化も。実は作者の城平京先生は「スパイラル 推理の絆」で有名な方で、漫画原作も達者です。鋼人七瀬編のコミカライズに抜擢されたのはこれが商業デビューとなる片瀬茶柴先生。この先生がまた素晴らしき御方で、琴子を蝶よ花よと可愛がってくださり、城平先生もコミックスを大変気に入られました。そして以降はたびたびコミックスが先行して世に出るようになったのです。めでたしめでたし。

虚構推理のコミカライズはただのコミカライズではないぞということで、漫画が読みやすい方はこちらを読んでいただいても構いません。ミステリ小説を読めと言っておいてなんなんですけども。ただ、小説版のターニングポイントである「虚構推理 逆襲と敗北の日々」の最終話は小説版とコミックス版で分岐があるので、どちらも読んでおいてほしい……。これは都市伝説解体センターで例えると、小説版で6話とエピローグの間に書き下ろしのセンター長の独白が収録されているようなものです。さらにはこのペーパーを書いている最中に2年振りの小説版最新刊「虚構推理 忍法虚構推理」にてアンサー編がお出しされ、こちとら絶賛阿鼻叫喚といった次第です。これは都市伝説解体センターで例えるとあらゆるメディアミックスが終わってブームも落ち着いたかと思われた1年後、センター長の独白を受けて突然DLCで5年後のあざみが登場、みたいな話でした。よくわからないですよね、すいません、こっちも混乱していて。

また、「奇々解体」を愛する皆さんには、アニメ化の際に書き下ろさせたアニメ1期オープニング「モノノケ・イン・ザ・フィクション」も是非聞いてほしいところです。琴子ちゃんの告白が胸に迫ります。都市伝説解体センター、アニメ化するんですかね。いかにもしそうですね。ということで、都市伝説解体センター好きにオススメのミステリ「虚構推理」編でした。

11月のオンリーでは「ハサミ男」編をお届けします。また次回お会いしましょう。